Dar visai neseniai net neįsivaizdavome, kad neuroninių tinklų era taip arti realybės. Dabar, regis, tai priartėjo prie mūsų ir labai greitai paveiks mūsų darbą ir gyvenimą.

Yra keletas tai įrodančių pavyzdžių. Dall-E 2, Midjourney ir Stable Diffusion neuroniniai tinklai, kurie per kelias sekundes sukuria neįtikėtinus piešinius pagal poreikį. Kinijos teismų sistema, kurioje dirbtinis intelektas priima sprendimus ir skelbia nuosprendžius, taip pat moksliniai atradimai, kuriuos mokslininkai padarė pasitelkę neuroninius tinklus, yra nauja realybė, prie kurios turime priprasti.

Prasidėjo nauja serija apie AI (angl. Artificial intelligence, dirbtinis intelektas) įgaunant sąmonę ir net savo kalbos išradimą. O metų pabaigoje pasidžiaugėme dar vienu kalbos modeliu – atnaujintu OpenAI GPT-3.5, kuris ne tik kuria labai kokybiškus tekstus, bet tikrai gali pakeisti kai kuriuos IT įmonių, tekstų kūrėjų ir net Google jaunesniuosius darbuotojus.

Tačiau šių neuroninių tinklų pasiekimų nereikėtų pervertinti. Bent jau taip tvirtina 45 metų Yejin Choi, šiemet gavusi MacArthur stipendiją (800 000 USD) už novatorišką dirbtinio intelekto kūrimo tyrimą. Anot jos, dabar šioje srityje daug ažiotažų ir baimės.

Apie sąmoningą dirbtinį intelektą

Žmonės daro skubotus apibendrinimus apie dirbtinį intelektą. „GPT-3.5 gali sukurti puikius tinklaraščio straipsnius, o GPT-4 gali būti laikraščio „New York Times“ redaktorius? Nemanau, kad tai realu, nes jis [AI] neturi supratimo apie politinius įvykius, todėl negalės parašyti ko nors aktualaus.”

Visada atsiranda žmonių, kurie tiki tuo, kas neturi prasmės – taro kortomis, sąmokslo teorijomis, sąmoningu dirbtiniu intelektu.

Žmonės linkę manyti, kad jei dirbtinis intelektas gali padaryti ką nors protingo, pavyzdžiui, versti ar žaisti šachmatais, jis turėtų labai lengvai atlikti paprastesnes užduotis. Tiesa ta, kad tai, kas lengva mašinoms, gali būti sunku žmonėms ir atvirkščiai.

Nustebtumėte, kaip sunku dirbtiniam intelektui suvokti pagrindinį sveiką protą. Jam tai mums kaip tamsioji materija. Mes žinome, kad tai egzistuoja, bet nežinome, kas tai yra. Tai yra neišsakytos, numanomos žinios, kurias turime. Tai taip akivaizdu, kad dažnai apie tai nekalbame. Pavyzdžiui, kiek akių turi arklys? Dvi. Mes apie tai nekalbame, bet visi tai žino.

Ar dirbtinis intelektas gali būti išmokytas priimti moralinius sprendimus?

Turime išmokyti AI, kad beveik kiekviena taisyklė turi išimtį. Būna atvejų, kai tai pasireiškia aiškiau, būna ir priešingų situacijų. Svarbu, kad jis suprastų, jog gali egzistuoti ir netikrumas – pavyzdžiui, skirtingos nuomonės tam tikru klausimu.

Turi būti tam tikros moralės taisyklės, bet net ir jos gali turėti išimčių. Pavyzdžiui, jūs negalite žudyti žmonių. Bet kas, jei tai gailestingumo žudymas? Kaip elgtis tokiu atveju?

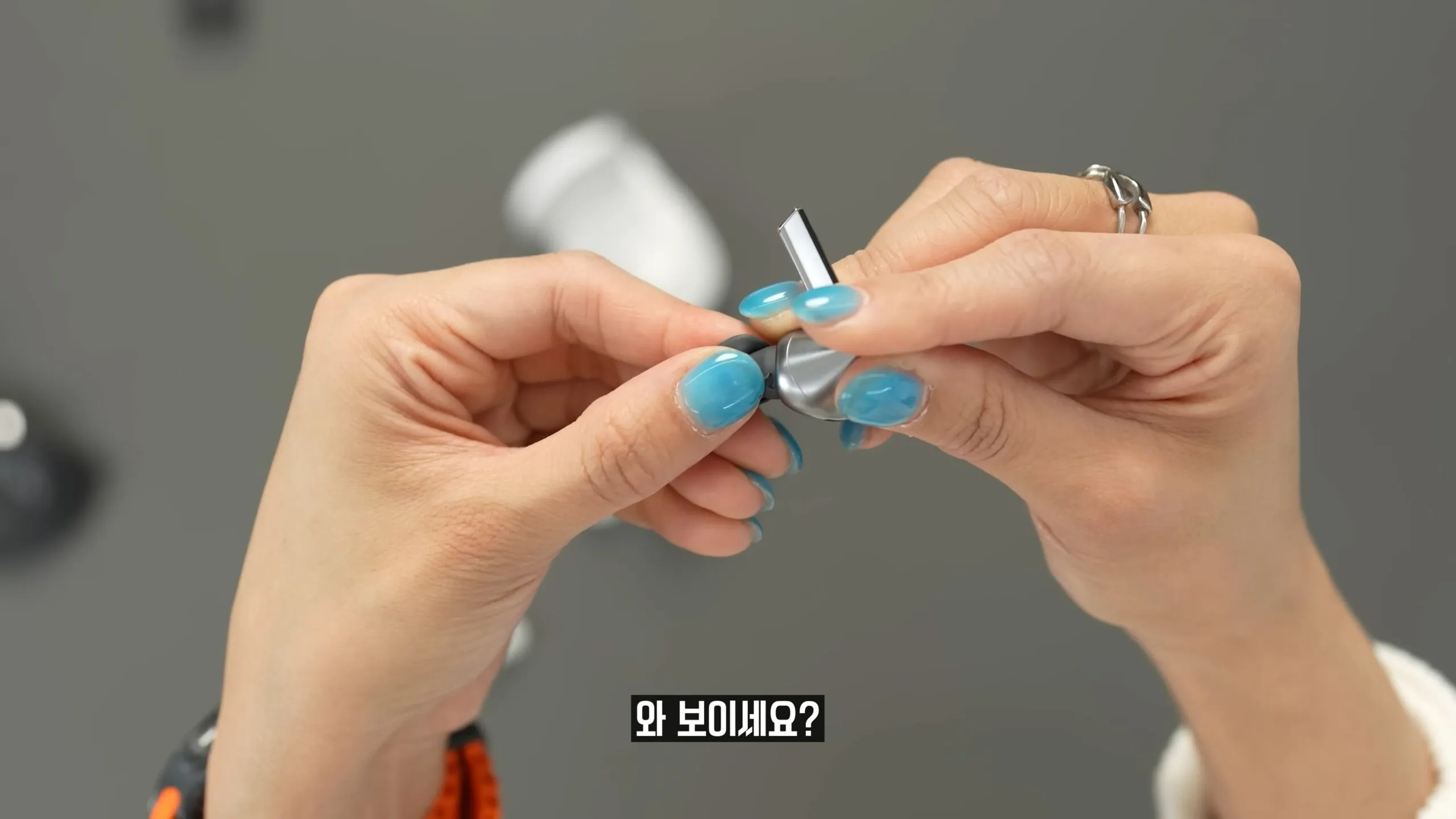

Kaip veikia dirbtinio intelekto kalbos modelis?

Jis numato, koks žodis bus kitas, atsižvelgiant į praeities kontekstą. Nėra akivaizdžios tiesos, kuris žodis turėtų būti šalia – beveik visada yra keletas variantų. Statistinio skirstymo pagalba AI gali pasirinkti geriausią žodį – manau, kad tokiu būdu jis galės priimti ir tam tikrus moralinius sprendimus.

Visada atsiras kažkas, kas norės panaudoti AI savo tikslams. Tikrai norime, kad dirbtinis intelektas galėtų priimti etiškus sprendimus, kurie gali būti neutralūs ar net prieštarauti galimai neetiškiems kūrėjų tikslams.